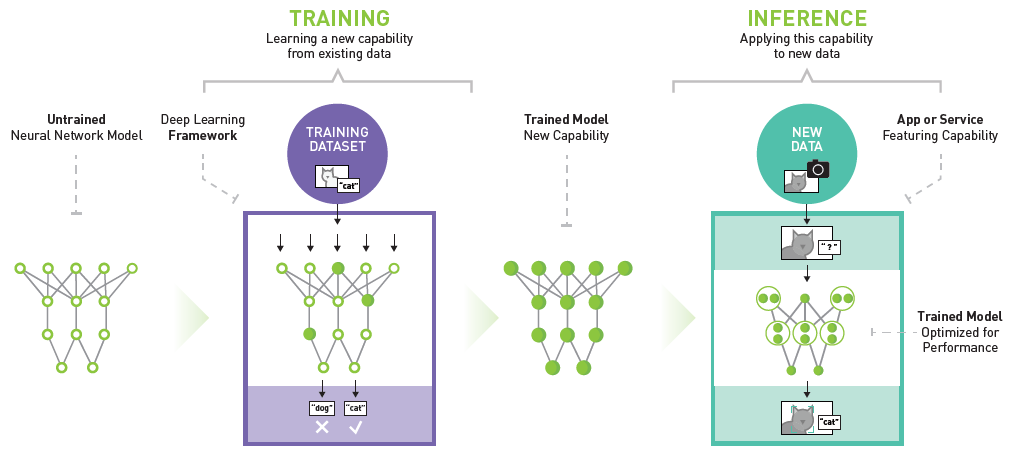

Data Center Deep Learning Product Performance Hub Nvidia Developer Inference: you want to understand how ozone levels are influenced by temperature, solar radiation, and wind. since you assume that the residuals are normally distributed, you use a linear regression model. 在哲学逻辑学、心理学、认知科学、(通用)人工智能等领域,如何对推理进行定义?reasoning和inference有….

Data Center Deep Learning Product Performance Hub Nvidia Developer Causal inference 和 llm 的结合是一个新兴的研究领域,具有广阔的应用前景。 随着研究的深入,causal inference 和 llm 将会更加紧密地结合,并为我们带来更多新的应用和突破。. 变分推断(variational inference)是一种用于近似后验分布的贝叶斯推理方法,通过优化变分下界(elbo)来找到最优的替代概率分布。. 推断(inference)可以使用低精度的技术,训练的时候因为要保证前后向传播,每次梯度的更新是很微小的,这个时候需要相对较高的精度,一般来说需要float型,如fp32,32位的浮点型来处理数据,但是在推断(inference)的时候,对精度的要求没有那么高,很多. 进一步地,operator variational inference (opvi) [19] 则重新审视了这个优化目标的设计问题,提出了一个更加general的框架,把kl纳入其中。 总的来说,相比前两类问题,这个问题的工作较少,毕竟我们总可以设计“更好”的优化算法来弥补优化目标的“缺陷”。.

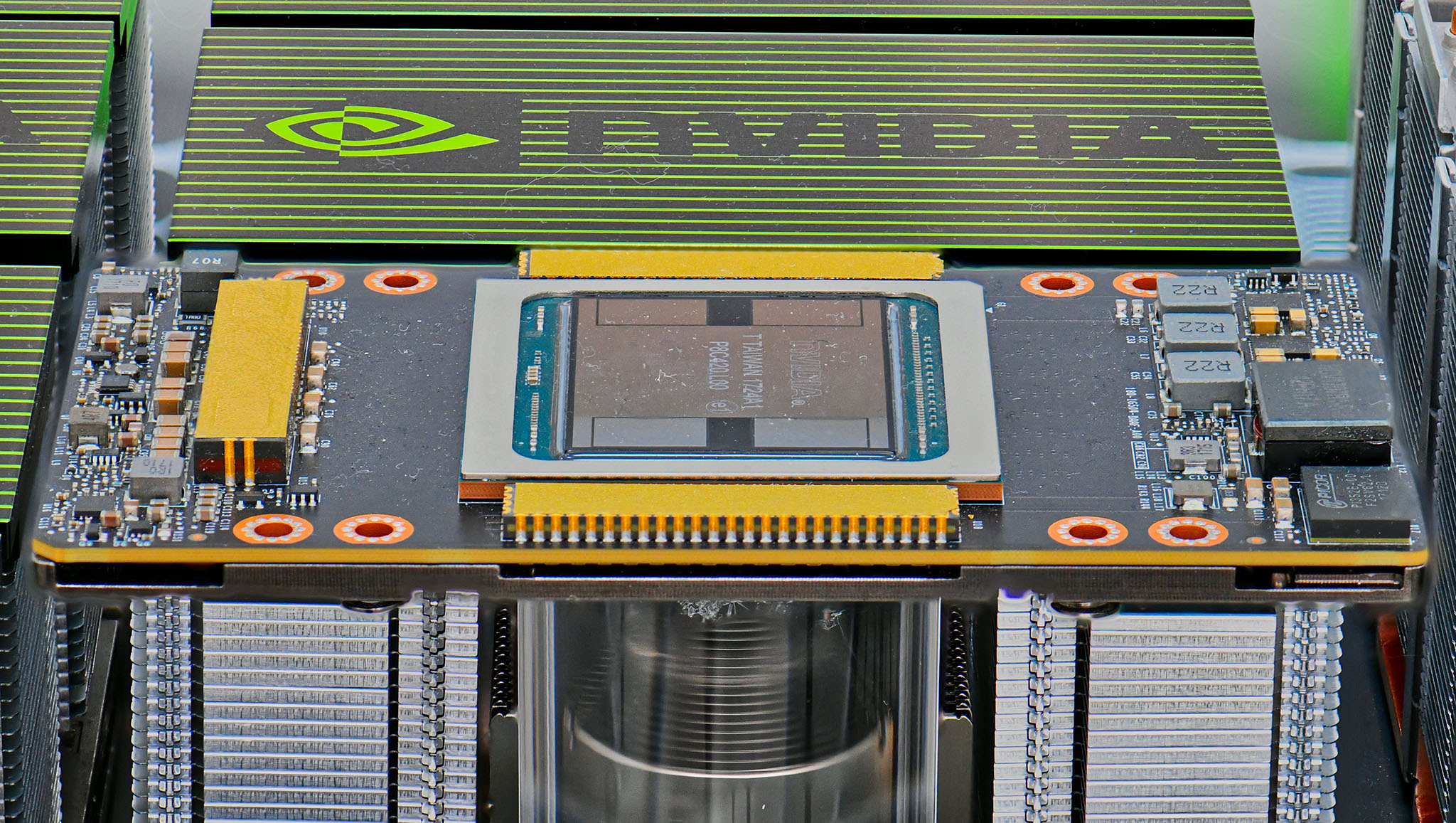

Nvidia Deep Learning Inference Platform Performance Study Nvidia 推断(inference)可以使用低精度的技术,训练的时候因为要保证前后向传播,每次梯度的更新是很微小的,这个时候需要相对较高的精度,一般来说需要float型,如fp32,32位的浮点型来处理数据,但是在推断(inference)的时候,对精度的要求没有那么高,很多. 进一步地,operator variational inference (opvi) [19] 则重新审视了这个优化目标的设计问题,提出了一个更加general的框架,把kl纳入其中。 总的来说,相比前两类问题,这个问题的工作较少,毕竟我们总可以设计“更好”的优化算法来弥补优化目标的“缺陷”。. High throughput generative inference of large language models with a single gpu, icml 23, stanford university 利用多级存储在单卡上推理大模型,将模型参数、activation和kv cache卸载到cpu或disk,每次只推理一小块mini batch和一小块模型。 设计优化问题决定batch size、卸载比例等参数。. 学习一个新领域需要先了解它的整体框架和知识脉络,再深入研究。所以近期我们先来分享一些经典综述型论文,希望能给感兴趣的伙伴提供一些思路和借鉴。首先附上原文链接: a survey on causal inference. 这里triton指的是triton inference server而不是openai的triton,注意区分 本篇也算是triton系列第二篇,接下里会借着triton这个库,一起讨论下什么是推理、什么是推理引擎、推理框架、服务框架等等一些概念,以及平常做部署,实际中到底会做些什么。. 看到问题和不少回答都提到了因果推断(causal inference)。 这是我主要的研究领域,所以也来说几句。 虽然因果推断是最近比较火热的方向,但这个问题早已根植在现代统计的起源。 提到统计的起源和遗传学(genetics)密切相关。.

Nvidia Deep Learning Inference Platform Performance Study Nvidia High throughput generative inference of large language models with a single gpu, icml 23, stanford university 利用多级存储在单卡上推理大模型,将模型参数、activation和kv cache卸载到cpu或disk,每次只推理一小块mini batch和一小块模型。 设计优化问题决定batch size、卸载比例等参数。. 学习一个新领域需要先了解它的整体框架和知识脉络,再深入研究。所以近期我们先来分享一些经典综述型论文,希望能给感兴趣的伙伴提供一些思路和借鉴。首先附上原文链接: a survey on causal inference. 这里triton指的是triton inference server而不是openai的triton,注意区分 本篇也算是triton系列第二篇,接下里会借着triton这个库,一起讨论下什么是推理、什么是推理引擎、推理框架、服务框架等等一些概念,以及平常做部署,实际中到底会做些什么。. 看到问题和不少回答都提到了因果推断(causal inference)。 这是我主要的研究领域,所以也来说几句。 虽然因果推断是最近比较火热的方向,但这个问题早已根植在现代统计的起源。 提到统计的起源和遗传学(genetics)密切相关。.

Inference Platforms For Hpc Data Centers Nvidia Deep Learning Ai 这里triton指的是triton inference server而不是openai的triton,注意区分 本篇也算是triton系列第二篇,接下里会借着triton这个库,一起讨论下什么是推理、什么是推理引擎、推理框架、服务框架等等一些概念,以及平常做部署,实际中到底会做些什么。. 看到问题和不少回答都提到了因果推断(causal inference)。 这是我主要的研究领域,所以也来说几句。 虽然因果推断是最近比较火热的方向,但这个问题早已根植在现代统计的起源。 提到统计的起源和遗传学(genetics)密切相关。.